Алгоритмы ИПС Google

Алгоритмы Google, основа работы поисковой системы Google. Созданная Ларри Пейджем и Сергеем Брином обновляя свои алгоритмы и сегодня способна найти документы на двух сотнях языках и произвести обработку данных базовых форматов (Microsoft Word, PDF, Excel и т.д.). Давайте в этой статье вспомним главные этапы развития алгоритмов Google, созданных для ранжирования веб-страниц в поисковой выдаче Google.

История развития алгоритмов Google по годам и алгоритмам

1998 год. В этот год был основан поисковик Google. В то же время был создан Page Rank (PR), алгоритм работы которого основывался на передаче ссылочной массы и имел два основных параметра:

- чем больше количество ссылок, ведущих на ту или иную страницу, тем выше уровень Page Rank и место, занимаемое в поисковой выдаче;

- чем выше уровень Page Rank ссылающихся веб-страниц, тем больше масса, передаваемая ссылками.

Официальным создателем PR является Лари Пейдж, а владельцем патента на данное изобретение – университет Стэнфорда.

Многие считают, что Page Rank переводится как «ранг страницы», но на самом деле это словосочетание переводится как «ранг Пейджа», создатель изобретения дал ему свое имя. В дальнейшем многие поисковики переняли идею Page Rank в качестве основы, разработав собственные аналоги инструмента.

21 век

2000 год

Компания Google представляет широкой общественности новую разработку – алгоритм под названием Hilltop, который позволяет наиболее точно рассчитать уровень PR. Данный алгоритм читает географию и степень новизны того или иного документа. После этого Google начинает оповещать веб-мастеров о том, чтобы они не оставляли ссылки на подозрительных веб-сайтах и «линко-помойках».

2001 год

В этот год компания Google регистрирует патент на алгоритм Hilltop. На этом же этапе поисковая система делит результаты поиска для некоммерческих и коммерческих запросов.

2003 год

15.11.13 запускается новейший алгоритм Florida, который убирает из выдачи либо понижает место страниц, содержание которых перенасыщено ключевыми фразами и словами. В этот день специалисты в области SEO поняли, что новый алгоритм поисковика понижает рейтинг страниц по следующим причинам:

- не уникальный либо низко уникальный контент;

- высокое содержание ключевиков в заголовках и текстах;

- ссылки неестественного вида (покупные).

2005 год

Специалисты Google впервые пробуют персонализировать поисковую выдачу, задав за основу предыдущие запросы того или иного пользователя.

2006 год. Компания запускает усовершенствованный алгоритм, базирующийся на алгоритме под названием Orion – детище студента из Израиля. Поисковая система теперь может находить совпадающие по тематике запроса веб-страницы, не содержащие ключевиков. С этого момента Google начинает «уточнять» запросы пользователя, предлагая варианты, которые чаще всего ищут с данным словом. К примеру, если пользователь набирает в поисковой строке слово «круг», система предлагает ему такие варианты запроса, как «круг песни», «круг для купания новорожденных» и т.д.

2007 год

Этом году история развития алгоритмов Google ознаменована запуском нового алгоритма Austin. Новинка способна учитывать уровень трастовости того или иного веб-ресурса и понижать в поисковой выдаче ресурсы с меньшим показателем трастовости. Таким образом, веб-сайты, которые не успели набрать траст.

2009 год

Разработчики Google внедряют в работу поисковой системы новый алгоритм Caffeine. Прошлые алгоритмы Google стали не соответствовать, возросшим производственным мощностям, благодаря чему поисковик начинает намного чаще производить индексирование сайтов, в результате чего во много раз ускоряется формирование страницы с результатами поисковой выдачи. Caffeine не сильно повлиял на формулу расчитывания релевантности, тем не менее стали заметны следующие изменения:

Постоянная индексация всего пространства всемирной паутины позволила поисковой выдаче Google стать гораздо динамичнее и меняться в течение дня.

- На первый план вышли содержание и частота обновления веб-сайта;

- Оптимизация, проведенная внутри сайта (удобство пользования, грамотная перелинковка) заметно повышает доверие поисковой системы к тому или иному ресурсу;

- Появляются определенные санкции за публикацию и рассылку спама;

- Появляются определенные санкции за наличие технических неполадок. К примеру, долгая загрузка веб-сайта или «битый» формат ссылок могут понизить ресурс в поисковой выдаче;

- Google начинает уделять больше внимания ресурсам и ссылкам таких сайтов, как Googlenews, Twitter, Googleblog.

Второе десятилетие 21 века

2011 год

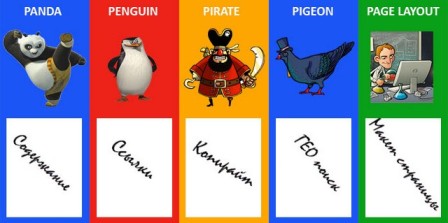

Специалисты пополняют алгоритмы Google своим «мусорщиком». Это запуск алгоритма под названием Panda – первый серьезный чистильщик выдачи. Новый алгоритм «чистит» поисковую выдачу от «плохих» сатов – сателлитов, дорвеев, сайтов, содержание которых представляет собой лишь рекламу и ссылки, а также сайтов с низкой уникальностью контента.

Создатели усовершенствованного алгоритма Мэтт Катс и Амит Сингал отмечают, что их новое детище учитывает следующие моменты:

- Процентный показатель уникальности содержания определенной страницы и на ресурсе в целом;

- Уровень шаблонности содержания, то есть схожесть текстов, написанных под различные ключевики;

- Наличие стилистических, грамматических и орфографических ошибок;

- Релевантность представленной на ресурсе рекламы к тематике размещенных текстов

- Соответствие содержания тегов и метатегов веб-страницы к ее контенту;

- Степень насыщенности размещенных текстов ключевиками;

- Уровень качества исходящих и входящих ссылок;

- Действия интернет-пользователя (длительность посещения сайта, число просмотренных веб-страниц, количество отказов и возвратов на ресурс).

Сегодня можно с уверенность отметить, что практически все современные поисковые системы учитывают данные факторы, в особенности – поведенческие. Чем интереснее контент сайта для интернет-пользователя, тем больше он проведет времени на данном ресурсе, и тем выше данный веб-сайт будет ранжироваться на странице поисковой выдачи.

Колибри

2013 год. В октябре алгоритмы Google пополнились новейшим алгоритмом «Колибри» – Hummingbird. Новшество данного алгоритма заключается в том, что он способен понимать даже скрытый смысл запросов. К примеру, если вы введете «купить что-либо около дома» Hummingbird по мет, что имеются в виду оффлайн-магазины. А из интернет-магазинов он выберет лишь те, на сайтах которых максимально подробно описана информация об условиях доставки и их преимуществах. Помимо этого, алгоритм Hummingbird предпочитает длинные, подробные запросы. Но при этом по тем запросам, по которым Google не сможет «пофантазировать», выдача не изменилась.

И еще один важный момент – неуникальное, низкоуникальное и сгенерированное содержание теперь не работает.

В завершение всего стоит отметить, что российский Google – один из наиболее удобных вариантов работы поисковой системы. В России Google не использует большую часть своих «карательных» санкций, благодаря чему продвижение сайтов для данной системы в России намного проще, чем для других поисковиков.

Пингвин и Панда

4.10. 2013 вышел алгоритм Пингвин 2.1

Как и ранее поисковик Google обращает внимание на подозрительные сайты и анкор-листы. Данное обновление алгоритма отразилось на ранние попадавшие под санкции алгоритма сайты. Затронуло 1% запросов.

19.05. 2014 год вышло обновление Панда 4.0

История развития алгоритмов Google на знала такого серьёзного обновления поискового алгоритма. Затронуло 7.5% поисковых запросов.

24.08. 2014 год, алгоритм Голубь

Алгоритм обратил внимание на геозависимые запросы. Теперь, при получении геозависимого запроса поисковик Google дает наиболее информативные, локальные результаты поиска для пользователя.

23.09. 2014 год. Обновление алгоритма Панда 4.1

Данное обновление основывалось на обобщении всех жалоб и комментариев от пользователей по алгоритму Panda 4.

17.10. 2014 год. Алгоритм Пингвин 3.0

Данный апдейт поисковика Google опять дал понять, что поисковик отрицательно относится к веб-спаму. Много сайтов просело в выдаче.

Последний алгоритм поисковика Google, алгоритм отслеживающий макт страницы, февраль 2014 год. Смыс, в том, чтобы реклама не занимала верхние позиции сайта.

Октябрь 2014. Google в очередной раз заявляет о борьбе с воровством контента обновляя алгоритм Pirate 2.0, который борется с нарушением авторских прав.

2015 год

mobile-friendly

С 21.04.15 года Google начинает мотивировать мобильный контент и запускает new алгоритм Mobilegeddon (//webmasters.googleblog.com/2015/04/rolling-out-mobile-friendly-update.html). Теперь в мобильной выдаче приоритет у сайтов имеющих адаптированную версию сайта. Название Mobilegeddon, взято из западных СМИ. У нас его назвали: mobile-friendly и я знаю почему. Появился инструмент проверки мобильной версии сайта: https://search.google.com/test/mobile-friendly.

За последние два года, сообщений о выходе принципиально новых алгоритмов, типа Панда или mobile-friendly, не было. Была шумиха с патчем алгоритма, под названием Фрэнд, который то ли наказывал, то ли не наказывал сайты с контентом «не для людей».

Были сообщение от Google, что более быстрые сайты будут иметь преимущества при ранжировании.

2016-2017

Сам Google в 2016 году предупреждал, а 2017 году заявлял, о необходимости перехода на протокол HTTPS и что станет помечать сайты, собирающие данные и продолжающие работать на незащищенном протоколе HTTP, что и сделал. Причем для всех сайтов, а не только собирающих данные и оплату.

Продолжаются разговоры про AMP версии с мотивацией их создания. Создан инструмент проверок: https://search.google.com/test/amp.

Однако, реальных принципиальных, официально заявленных алгоритмов Google, затрагивающих всю выдачу, не было. Но все мы понимаем. что история развития алгоритмов Google не закончена, хотя такое ощущение, что выдача на “больших машинах” Google скоро не будет интересовать.

©www.wordpress-abc.ru

Другие статьи раздела SEO

- Способ раскрутки сайта, стандартный алгоритм

- Внутренние факторы ранжирования, как основная задача веб-мастеров

- Как работают поисковики Интернет

- Оптимизированная структура сайта

- Что такое каталог Яндекс, адрес каталога, как попасть в каталог Яндекс

- Поисковые системы Интернет: Яндекс, Google, Mail, Bing, Рамблер

- Частотность запросов, высокочастотные и низкочастотные запросы